美國健康保險公司UnitedHealthcare涉嫌使用AI推翻醫生的判斷以拒賠患者醫療費,被病人家屬聯合上訴。

UnitedHealthcare是美國最大的健康保險公司,2019 年11月,該公司開始使用 nH Predict人工智慧算法,該AI算法用於估算病人需要多少後期護理,通過在包含600萬個病例的資料庫中提取資訊,來估算後期護理大致需要多久。保險公司的人只需要將客戶的年齡、生活狀況、身體機能等資訊輸入進去,AI就會自動給出一系列估計,包括客戶的醫療需求是什麼、出院日期在哪天等。

AI with 90% error rate forces elderly out of rehab, nursing homes, suit claims https://t.co/dAG5pzP9t5

— Ars Technica (@arstechnica) November 16, 2023

然而,nH Predict有嚴重缺陷,它並不能預測醫療併發症,患者往往在療養院住不超過14天,就會收到拒保通知。更致命的是,這款AI算法是NaviHealth開發的,而NaviHealth則是UnitedHealthcare的子公司。也就是說,該AI推斷出來的結果,全由UnitedHealthcare控制。

2022年,91歲的吉恩(Gene Lokken)在家中摔倒。老人骨質較為疏鬆,腿骨和腳踝均發生骨折。在醫院住了六天后,他被轉移到護理中心,又花了一個月逐漸恢復。醫生說他的情況有所好轉,可以開始物理治療了。

對老人來說,物理治療註定是一個漫長的過程,然而僅在19天之後,UnitedHealthcare就拒絕再支付治療費,並發出一封拒絕信,稱「他沒有嚴重的醫療問題。」但醫生和治療師均認為老人的肌肉功能仍然「麻痹且虛弱」,也就是說應該繼續治療。

家人很憤怒,向保險公司提出異議,但也被對方駁回,無奈下只得自掏腰包,直到老人過世。這家人在買了保險的情況下,仍多花了15萬美元(約117萬港幣)。

UnitedHealthcare官網截圖

類似的,74歲老人戴爾(Dale Tetzloff)突發中風,住院治療後,醫生將其轉到一家專業的護理院,說他需要至少100天的後續護理。僅僅住了20天,UnitedHealth便拒絕繼續付款。

他的家人給UnitedHealth連續發了兩次異議,在第二次,經NaviHealth的醫生審查後,保險公司同意繼續付款。然而住到第40天時,保險公司再度停了付款,並且拒絕給出理由。家人又嘗試發出異議,可再也沒成功,老人被轉移到養老院四個月後便過世了,從老人中風到去世這段時間,他的家人額外多花了約7萬美元(約54萬港幣)。

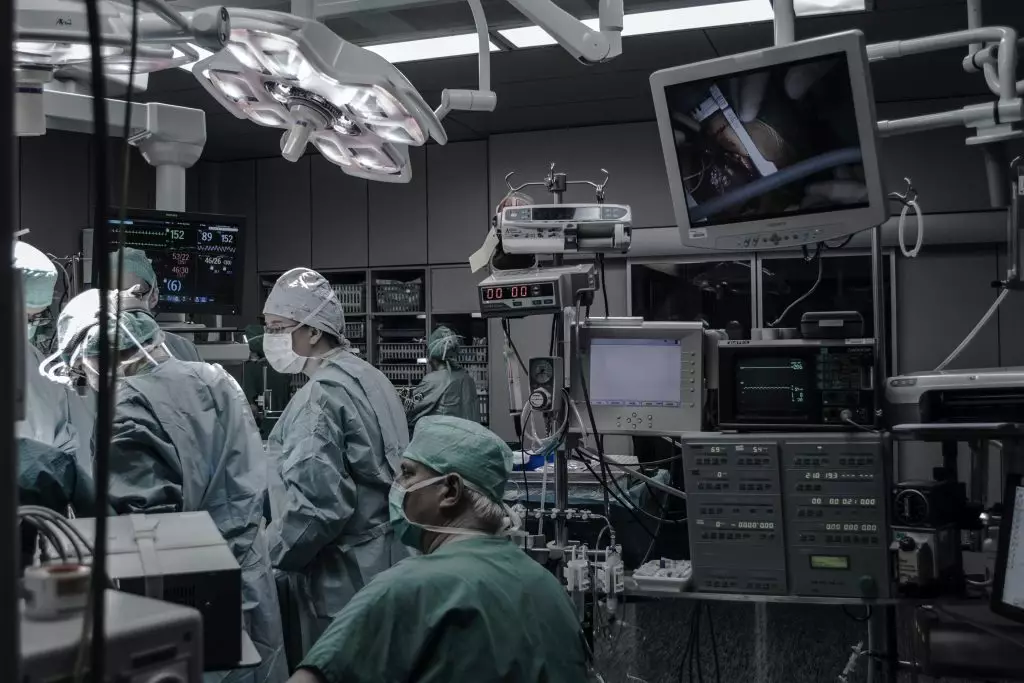

示意圖。設計圖片

為了討回公道,早前這兩家人聯合起來,將UnitedHealthcare告上了法庭。他們還在尋找全美各地的數萬名潛在受害者,打算進行集體訴訟。在訴訟進行期間,有媒體對UnitedHealth展開了調查,而調查結果很大程度上和兩家人的主張吻合,即該公司使用了存在嚴重缺陷的AI演算法來推翻醫生的判斷。

訴訟文件稱,當患者或者醫生要求查看AI生成的報告時,會被UnitedHealth以“商業機密”為由拒絕。而且,如果醫生執意反對AI做出的判斷,UnitedHealth也會依然以AI為准,這背後的原因是:醫生的判斷太費錢,而AI能省錢。

示意圖。設計圖片

根據幾個匿名前員工的爆料,自2020年UnitedHealth收購了NaviHealth後,公司的重點就開始朝著績效、指標轉移了。儘管AI有著明顯的缺陷,但是在過去兩年中,員工們得到的指示仍然是盡可能靠近AI的預測,也就是儘早讓患者出院,給公司省錢。

沒人知道UnitedHealth究竟通過AI省了多少錢,據外媒估計每年能省幾億美元,但具體數字只能猜測,目前,該訴訟仍在進行中。