香港中文大學星期四(6月19日)舉行「善假於物‧『巫筆』AI教學研討會2025」,吸引近300位教育界人士及教師參與,座無虛席。會上公布,由香港中文大學、香港理工大學及香港科技園支持研發的人工智能批改工具「巫筆」,推出一年來已批改逾10萬篇作文,最新版本「v8」短短三個月內批改超過3萬篇;中學版本一年間吸引161間學校試用,當中80間已付費訂閱,成為教師優化語文教學的得力夥伴。

人工智能批改工具「巫筆」

語文教師長期面臨工時長、壓力大的挑戰,傳統作文批改耗時且回饋難以精準及時,學生缺乏個性化指導,學習效果受限。「巫筆」以科技解決這一痛點,致力與教育工作者共同推動語文教育革新,重塑語文教學未來。

「善假於物‧『巫筆』AI教學研討會2025」現場座無虛席,與會者專注聽取中大教育學院劉潔玲教授分享

「巫筆」積極與大專院校合作拓展應用場景:與香港中文大學中文系共同開發「爾雅」,用戶突破3000位;獲樹仁大學邀請開發中英文學術寫作輔助工具;更為中大教育學院劉潔玲教授量身打造寫作教學工具「自主寫意」,進一步挖掘AI在教育領域的潛力。

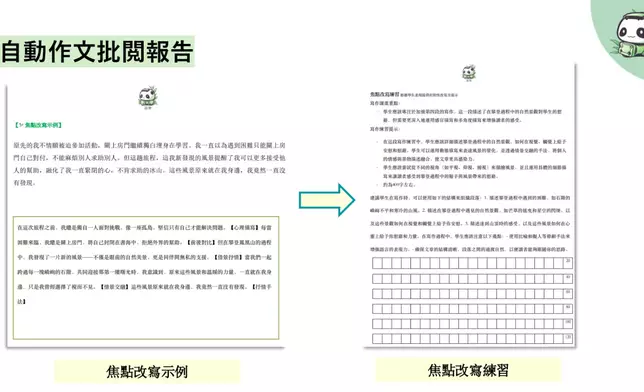

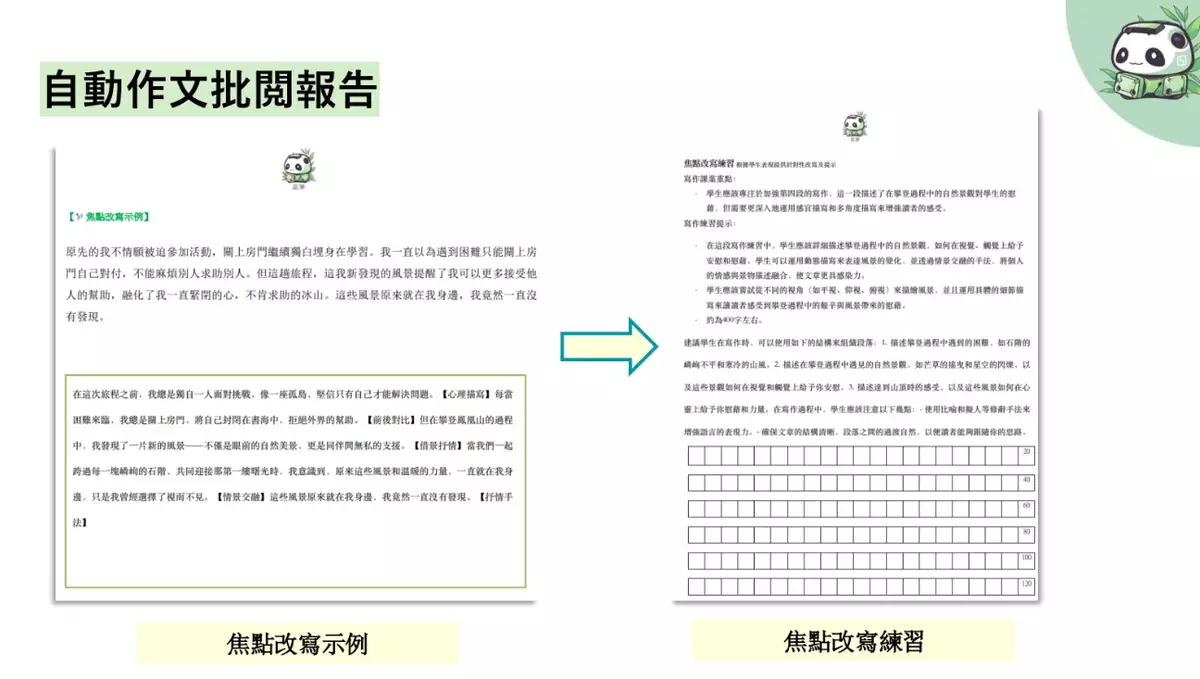

團隊強調,「巫筆」始終以教師需求為核心迭代升級。早期版本未包含評分功能,經教師反饋後,研發獨家計分程式,將專業評判權交還教師,AI則提供建議與評語代勞,實現「科技輔助,教師主導」理念。其「整體報告」功能以視覺化數據呈現學生能力點分析,解決傳統回饋碎片化問題,推動「評估推動學習」目標。

為覆蓋不同學習階段,「巫筆」已推出小學批改功能,支持自訂評分準則;並開發英文版本,目前開放免費試用。團隊更計畫進軍IGCSE、IELTS等國際考試,已取得初步研究成果,旨在通過科技實現系統化、量化的學習回饋。

「巫筆」堅持「AI建議,教師把關」模式,獨家計分程式允許教師調整權重,確保專業主導。未來將推出「個人寫作檔案」幫助學生追蹤進步,或比較全港學校表現,善用數據促進學習,既減輕教師負擔,亦為高階思維發展創造空間。

多所試用學校分享實踐經驗,顯示「巫筆」有效提升教學效率。旅港開平商會中學在中五、中六級試用文憑試及校本題目,教師有序加插AI批閱部分課業,引導學生理解AI批改意義。學生完成寫作後即時上載報告,教師先綜覽全班表現,後續課堂針對文類特點講解通病,並指導學生細閱批改報告,透過優點、不足及改善建議反思寫作,比較改寫示例學習技巧。

聖公會林裘謀中學全校各級試用初中校本及高中文憑試題目,主要採用兩種形式:一是教師利用生成評語輔助個人評改,回饋學生並讓其撰寫反思;二是抽出學生示例及巫筆評語,讓學生分組討論評語適切性及改寫建議,教師再加以點撥評講。

五旬節聖潔會永光書院在中三至中五全級試用2題文憑試及3題校本題目,老師表示,傳統手改難以及時整合常見問題或比對各班表現,而「巫筆」能在批改後迅速提供整體成績分佈、常見錯誤及亮點等統計,節省大量盤點統計時間,結合教師觀察可進行更深度教研討論。

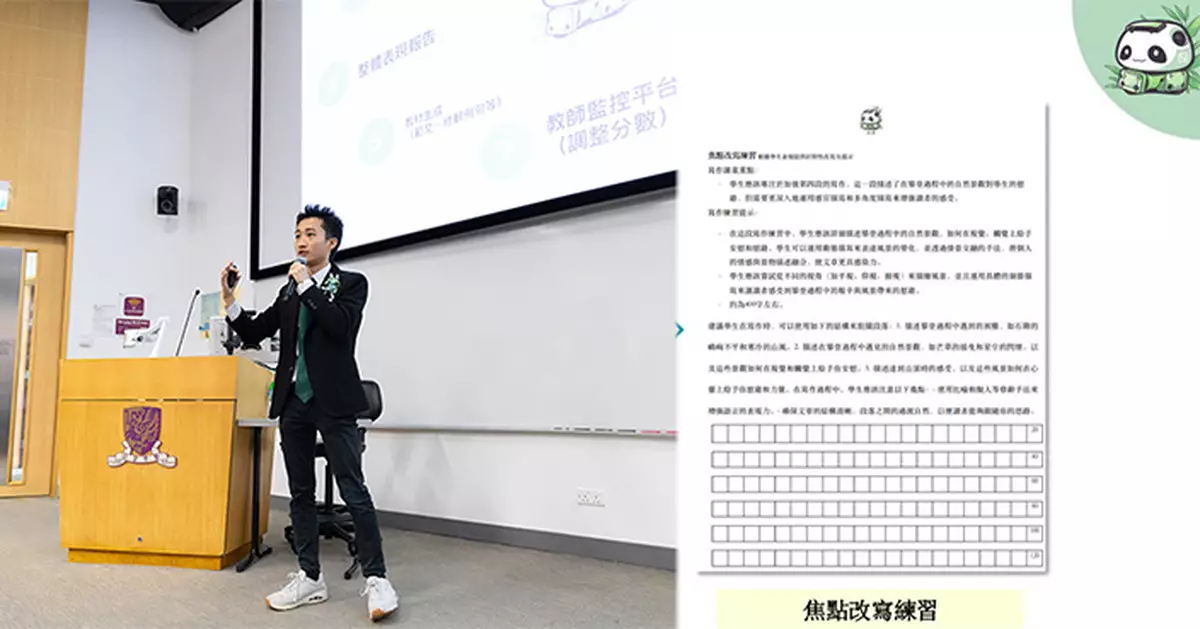

「巫筆」創辦人鄭樂之

「巫筆」創辦人鄭樂之表示:「我們相信AI能解放教師的勞動力,讓其更專注於『育人』。科技不是取代教師,而是擴展教育的可能性。」未來團隊將繼續與學校緊密合作,探索AI教學潛力,為語文教育注入新動力。