香港科技大學首席內地事務官、香港生成式人工智能研發中心(HKGAI)首席運營官、香港科技大學人工智能媒體博士後研究員黃紅英博士星期二(20日)應邀出席由香港特區政府數字辦公室舉辦的「網絡安全論壇」。面對生成式 AI(Generative AI)帶來的安全變局,黃紅英博士在會上分享了 HKGAI 的研發實踐經驗。她強調,AI 安全需實現從管控到主動預測的跨越,AI 安全需要透過嚴謹的工程化手段,讓AI 行為做到「看得見、存得下、算得清」。

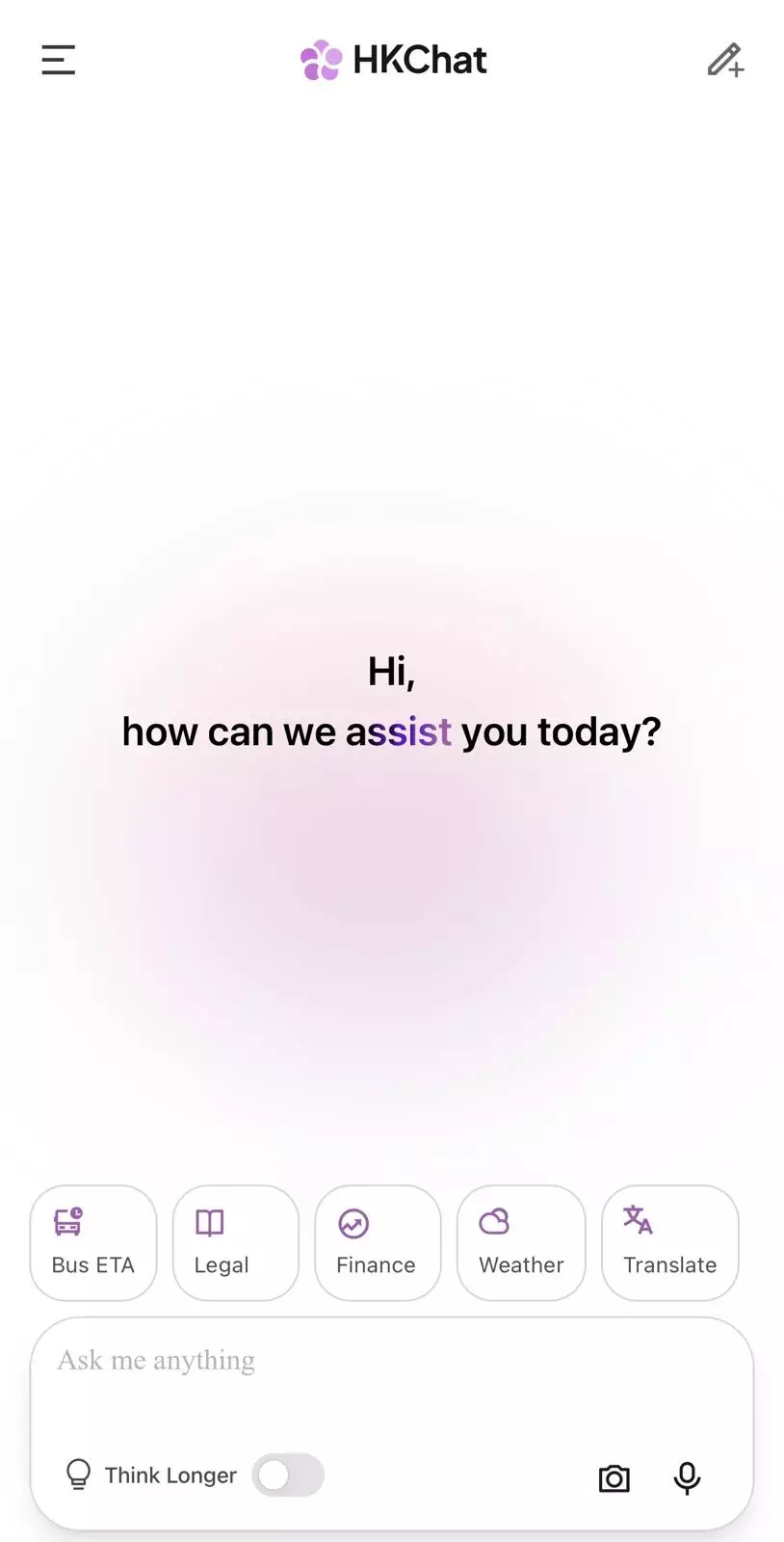

「港話通」(HKChat)已登陸「智方便」平台。資料圖片

黃紅英博士首先介紹了由HKGAI 研發的本地 AI 助手「港話通」的發展情況。她指出,「港話通」自去年 11 月 20 日正式上線以來,短短兩個月內,註冊用戶已突破 63 萬。面對大量用戶每日提出的本地化問題——從「哪裏的叉燒包最好吃?」到「如何由科大前往政府總部出席會議?」,黃博士坦言這是「壓力與動力並存」。她指出,用戶需要的不是通用的標準答案,而是比一般搜尋引擎更聰明、更實時且具備香港語境的精準回應。針對公眾關注的 AI 安全議題,黃博士希望將風險控制在「可看見、可接受」的範圍內。

生成式 AI與傳統軟件差異決定安全防護升級必然性

黃紅英博士指出生成式 AI 與傳統軟件的本質差異:「傳統軟件是按固定規則執行,但生成式 AI 是基於數據和上下文生成內容,所以風險不僅是系統本身,而是貫穿數據、由輸入到輸出的全過程。」

「當前不少 AI 安全建設仍停留在『堵漏洞』階段,但隨著技術在公共服務、法律諮詢等領域的深度應用,被動防禦已無法匹配業務需求,主動預測才是破解安全難題的關鍵。」

圖一:黃紅英博士(中)20日應邀出席由香港特區政府數字辦公室舉辦的「網絡安全論壇」。

築牢基礎能力:主動預測的核心前提

談及HKGAI 的實踐經驗,黃紅英博士強調,實現主動預測的前提是築牢基礎能力。「很多時候 AI 安全風險難以預警,並非算法不足,而是系統『看不清、算不清』。」HKGAI 在產品研發中,首先補齊日誌、調用鏈、輸入輸出全流程數據沉澱,確保模型行為可追溯、可監測;同時通過自研評測框架形成可分析、可復盤的安全數據體系,為主動預測提供數據支撐。

針對生成式 AI面臨的數據風險、語言誘導、幻覺問題,黃紅英博士介紹了 HKGAI 的分層防控策略:

• 在數據源頭構建本地可追溯知識庫,如「港法通」的嚴格回答是基於香港官方法條與判例,同時會強制引用來源;

• 在系統層加入輸入約束、提示詞審核與安全重寫機制,抵禦越獄誘導;

• 通過 RAG、Agent 搜索及輸出校驗機制,約束模型行為,降低幻覺風險。

港話通

三大重點佈局推動「主動預測」落地

展望未來6至12個月,黃紅英博士認為推動網絡安全從「被動防禦」走向「主動預測」的最大障礙是在於未打好基礎建設。「如果日誌不統一、連模型一次異常輸出是怎麼來的都搞不清楚,根本不可能做到提前預警。」她建議業界應優先處理三大範疇:

1. 補齊可觀測性:完善日誌與調用鏈,確保模型行為從頭到尾都有跡可循。

2. 數據驅動評估:解決數據零碎問題,將評估從「人盯人」升級為數據驅動、可量化的體系。

3. 培養複合型團隊:建立「懂模型、懂數據且懂安全」的團隊,將安全考量前置於設計階段。

呼籲用戶共創:反饋機制助模型迭代

黃紅英博士特別提到「修復機制」,呼籲市民在使用「港話通」時,若發現資訊滯後或錯誤,可以即時作出反饋。她表示,來自真實用戶的指正是優化模型最寶貴的養分,HKGAI 亦期待與全港市民共同改進這款屬於香港的本土大模型。

她表示,生成式 AI 的創新應用與安全防護是辯證統一的關係。HKGAI將持續以「看得見、存得下、算得清」為原則,培養「懂模型、懂數據、懂安全」的複合型人才,持續探索主動預測式 AI 安全體系,為香港 AI 產業高質量發展築牢安全屏障,助力 AI 技術在更多領域安全落地。