清華大學研發團隊近日成功研製出了全球首款類腦互補視覺芯片,名為「天眸芯」,未來將運用在智慧駕駛等領域。

清華大學研「天眸芯」 全球首款「類腦互補視覺」晶片

北京清華大學類腦計算研究中心的團隊最近成功研製出了全球首款類腦互補視覺芯片,名為「天眸芯」。該芯片能夠以極低的頻寬和功耗實現高速、高精度、高動態範圍的視覺資訊採集,並能夠高效應對各種極端場景,確保系統的穩定性和安全性。

微博圖片

傳統視覺感知芯片往往會出現失真等狀況

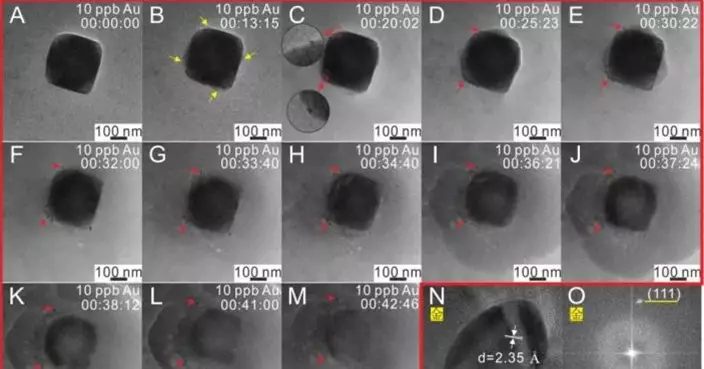

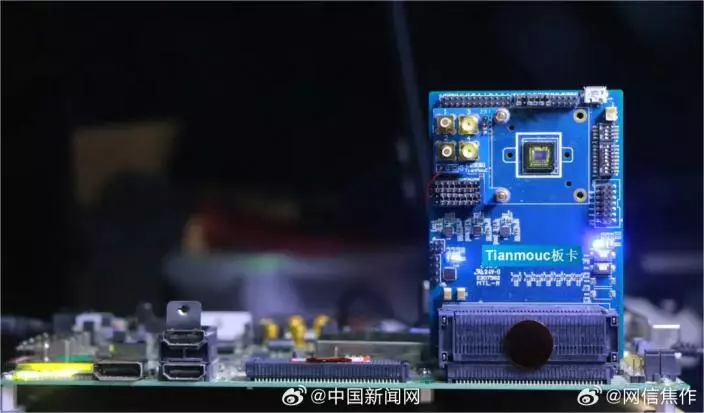

清華大學精密儀器系教授施路平指出,在開放世界中,智能系統需要應對龐大的數據量,同時還需要應對例如駕駛場景中的突發危險、隧道口的劇烈光線變化和夜間強閃光干擾等極端事件。傳統的視覺感知芯片在這些場景下往往會出現失真、失效或高延遲,從而限制了系統的穩定性和安全性。

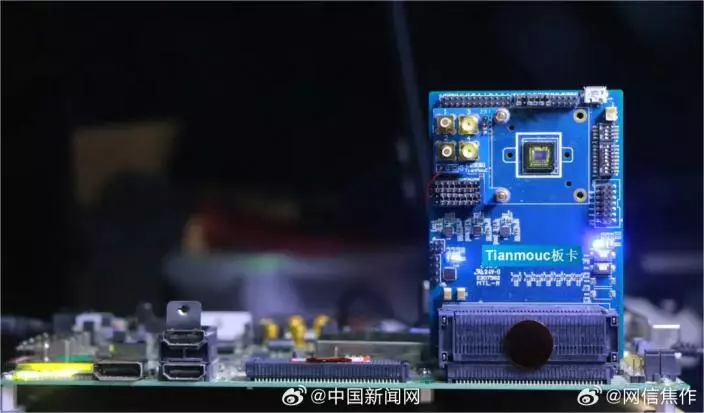

天眸芯(微博圖片)

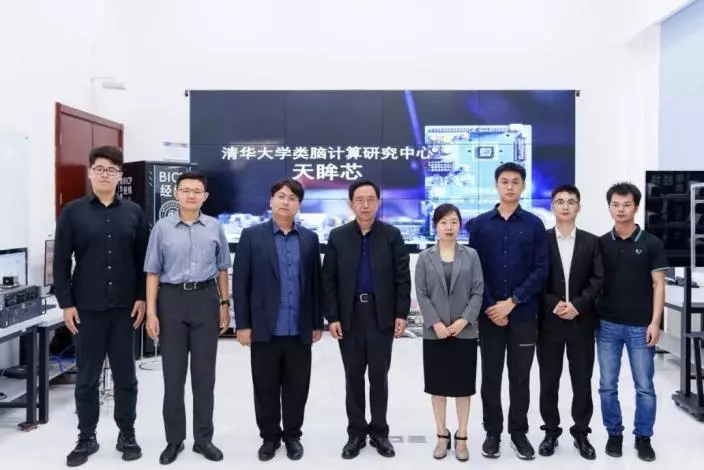

為了提升智慧駕駛的應用和安全性能,清華大學類腦計算研究中心的團隊專注於類腦視覺感知芯片技術,提出了一種基於視覺原語的互補雙通路類腦視覺感知新模式。

模仿人類視覺系統特徵 形成兩條互補且信息完備的視覺感知通路

施路平解釋說,這種模式借鑒了人類視覺系統的基本原理,將開放世界的視覺信息拆解為基於視覺原語的信息表示。通過有機組合這些原語,模仿人類視覺系統的特徵,形成了兩條互補且信息完備的視覺感知通路。

微博圖片

「天眸芯」將為自動駕駛領域開闢新道路

清華大學精密儀器系教授趙蓉強調,「天眸芯」將為自動駕駛、具身智能等重要應用開闢新的道路。該技術與團隊在類腦計算芯片、類腦軟件工具鏈和類腦機器人方面的應用落地相結合,能夠進一步完善類腦智能生態,有力推動人工通用智能的發展。

微博圖片

最新研究表明,嬰兒在2個月大時已能區分周圍看到的不同物體,這一時間點比科學家原先認為的更早。

研究:嬰兒與周圍世界的互動方式「比想像的要複雜得多」

據美聯社報導,這項研究結果於2日發表在《自然神經科學》(Nature Neuroscience)期刊上,可能有助於醫生和研究人員更深入了解嬰兒期的認知發展。主要作者、來自愛爾蘭都柏林三一學院的歐道赫提(Cliona O’Doherty)表示,研究發現嬰兒與周圍世界的互動方式「比我們想像的要複雜得多」。

這項研究分析了130名2個月大嬰兒的數據,這些嬰兒在清醒狀態下接受了腦部掃描。在這過程中,嬰兒觀看了生命第一年中常見的十幾種影像,例如樹木和動物。

歐道赫提指出,當嬰兒看到像貓之類的影像時,他們的大腦會以特定方式「觸發」,研究人員能夠記錄這一情況;而如果他們看到無生命物體,大腦的反應方式則會不同。

這項技術被稱為「功能性磁振造影」(fMRI),使科學家能夠比以往更準確地檢視視覺功能。過去許多研究依賴於測量嬰兒注視物體的時間長短,但在年齡較小的嬰兒身上難以準確評估。一些先前的研究認為,嬰兒需要到3至4個月大時才能區分動物和家具等不同類別。

2個月大就能分辨貓與傢俱

歐道赫提說:「我們的研究證實,他們在2個月大時已具備這種分辨類別的能力。這比我們先前的認知複雜得多。」

在這項研究中,許多嬰兒在9個月大時再次接受了檢查,研究人員成功收集了66人的資料。歐道赫提表示,相較於2個月大時,9個月大的嬰兒大腦更有效地區分生物和非生物。研究人員指出,未來科學家或許能將這類腦部影像與日後的認知結果聯繫起來。

對極幼小嬰兒進行腦部造影具有挑戰性

法國國家科學研究中心(CNRS)的神經科學家帕佩奧(Liuba Papeo)指出,對極幼小嬰兒進行腦部造影具有挑戰性,「或許最明顯的挑戰之一是,嬰兒需要在清醒狀態下舒適地躺在fMRI掃描儀中,並保持靜止。」

最新研究表明,嬰兒在2個月大時已能區分周圍看到的不同物體,這一時間點比科學家原先認為的更早。資料圖